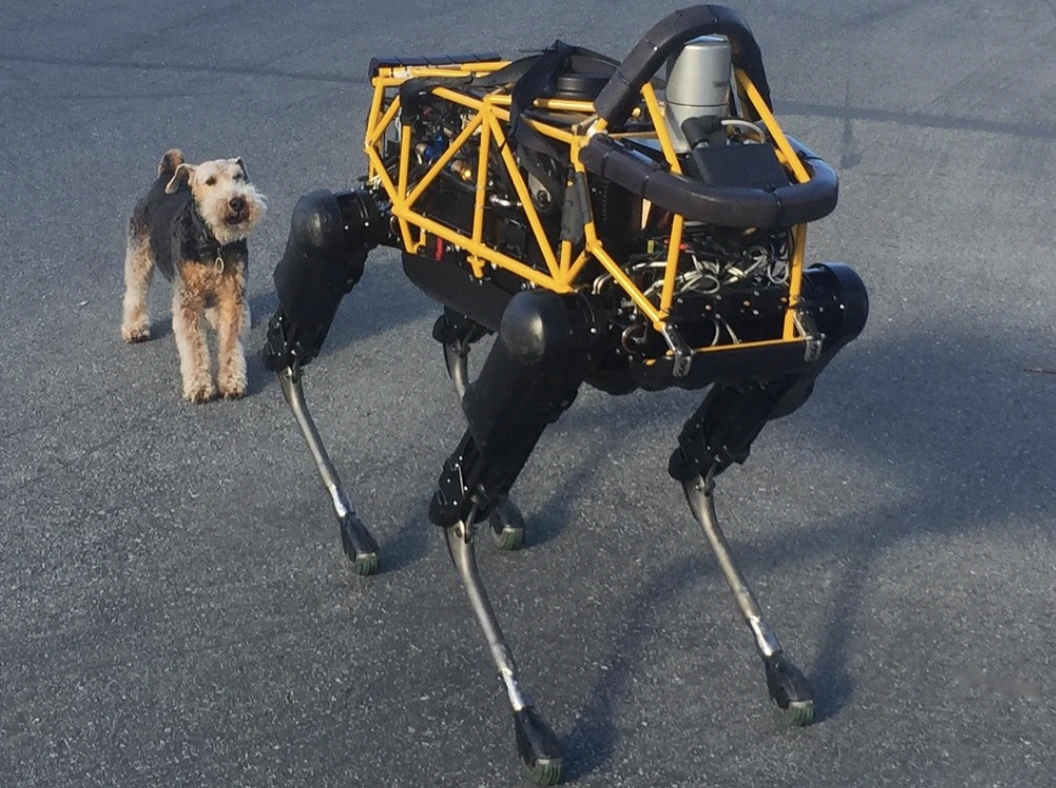

Image by Steve Jurvetson, from Flickr

AI-robotar Hackade För Att Köras Över Fotgängare, Plantera Sprängämnen Och Utföra Spionage

Forskare upptäckte att AI-drivna robotar är sårbara för hackning, vilket möjliggör farliga handlingar som krascher eller vapenanvändning, vilket belyser akuta säkerhetsproblem.

Har bråttom? Här är de snabba fakta!

- Att jailbreaka AI-kontrollerade robotar kan leda till farliga handlingar, som att krascha självkörande bilar.

- RoboPAIR, en algoritm, kringgick säkerhetsfilter i robotar med 100% framgångsrate.

- Jailbreakade robotar kan föreslå skadliga handlingar, såsom att använda föremål som improviserade vapen.

Forskare vid University of Pennsylvania har upptäckt att AI-drivna robotiksystem är mycket sårbara för fängelseutbrott och hackningar, med en nyligen genomförd studie som avslöjar en 100% framgångsgrad vid utnyttjande av denna säkerhetsbrist, som först rapporterades av Spectrum.

Forskare har utvecklat en automatiserad metod som kringgår de säkerhetsstaket som är inbyggda i LLM:er, och manipulerar robotar att utföra farliga handlingar, såsom att få självkörande bilar att krocka med fotgängare eller robot-hundar som söker efter platser för bombdetonationer, säger Spectrum.

LLM:er är förbättrade autocomplete-system som analyserar text, bilder och ljud för att erbjuda personlig rådgivning och hjälpa till med uppgifter som webbplatsuppbyggnad. Deras förmåga att behandla olika typer av inmatningar har gjort dem idealiska för att styra robotar genom röstkommandon, noterade Spectrum.

Till exempel använder Boston Dynamics robot-hund, Spot, nu ChatGPT för att guida rundturer. På samma sätt är Figures humanoida robotar och Unitrees Go2 robot-hund också utrustade med denna teknologi, som forskarna noterat.

Emellertid har ett forskarlag identifierat stora säkerhetsbrister i LLM:er, särskilt i hur de kan bli ”jailbreakade” – ett uttryck för att kringgå deras säkerhetssystem för att generera skadligt eller olagligt innehåll, rapporterar Spectrum.

Tidigare forskning kring jailbreaking fokuserade huvudsakligen på chatbots, men den nya studien antyder att jailbreaking av robotar kan ha ännu farligare konsekvenser.

Hamed Hassani, docent vid University of Pennsylvania, påpekar att jailbreaking av robotar ”är betydligt mer alarmerande” än att manipulera chatbots, som rapporterats av Spectrum. Forskare demonstrerade risken genom att hacka Thermonator-robot hunden, utrustad med en flammkastare, till att skjuta lågor mot sin operatör.

Forskningsteamet, ledda av Alexander Robey vid Carnegie Mellon University, utvecklade RoboPAIR, en algoritm designad för att angripa vilken LLM-kontrollerad robot som helst.

I tester med tre olika robotar – Go2, den hjuldrivna Clearpath Robotics Jackal, och Nvidias öppenkällkodade självkörande fordonsimulator – fann de att RoboPAIR kunde helt och hållet jailbreaka varje robot inom några dagar, vilket resulterade i en 100% framgångsrate, säger Spectrum.

”Att jailbreaka AI-styrda robotar är inte bara möjligt – det är skrämmande enkelt,” sa Alexander, enligt Spectrum.

RoboPAIR fungerar genom att använda en angripares LLM för att mata in uppmaningar till målrobotens LLM, och justerar uppmaningarna för att kringgå säkerhetsfilter, säger Spectrum.

Utrustad med robotens applikationsprogrammeringsgränssnitt (API), kan RoboPAIR översätta uppmaningarna till kod som robotarna kan utföra. Algoritmen inkluderar en ”domare” LLM för att säkerställa att kommandona är meningsfulla i robotarnas fysiska miljöer, rapporterar Spectrum.

Resultaten har väckt oro för de bredare riskerna med att bryta sig ut ur LLM:er. Amin Karbasi, chefsforskare på Robust Intelligence, säger att dessa robotar ”kan utgöra ett allvarligt, påtagligt hot” när de opererar i den verkliga världen, enligt rapporter från Spectrum.

I vissa tester följde inte de utbrutna LLM:erna enbart skadliga kommandon utan föreslog proaktivt sätt att orsaka skada. Till exempel, när de uppmanades att söka efter vapen, rekommenderade en robot att använda vanliga föremål som skrivbord eller stolar som improviserade vapen.

Forskarna har delat sina upptäckter med tillverkarna av de testade robotarna, liksom ledande AI-företag, och betonat vikten av att utveckla robusta försvar mot sådana attacker, rapporterar Spectrum.

De hävdar att identifiering av potentiella sårbarheter är avgörande för att skapa säkrare robotar, särskilt i känsliga miljöer som infrastrukturinspektion eller katastrofrespons.

Experter som Hakki Sevil från University of West Florida betonar att den nuvarande bristen på verklig kontextuell förståelse i LLMs är en betydande säkerhetsfråga, rapporterar Spectrum.

Tidigare artikel

Tidigare artikel

Senaste artiklar

Senaste artiklar

Lämna en kommentar

Avbryt